中期国际mt4注册这个问题在中文方面尤为明显

中期国际mt4注册这个问题在中文方面尤为明显雷锋网 AI 科技评论音讯,Google 近期提出的 BERT 模子,通过预测障蔽的词,愚弄 Transformer 的众层 self-attention 双向修模技能,得到了很好的成效。然而,BERT 模子的修模对象紧要聚焦正在原始说话信号上,较少愚弄语义学问单位修模。这个题目正在中文方面尤为分明,比方,BERT 正在处分中文说话时,通过预测汉字实行修模,模子很难学出更大语义单位的无缺语义体现。比方,对待乒 [mask] 球,清明上 [mask] 图,[mask] 颜六色这些词,BERT 模子通过字的搭配,很容易推断出掩码的字新闻,但没有显式地对语义观念单位 (如乒乓球、清明上河图) 以及其对应的语义联系实行修模。

设思借使也许让模子研习到海量文本中包含的潜正在学问,势必会进一步提拔各个 NLP 职业成效。基于此,百度提出了基于学问巩固的 ERNIE 模子。

ERNIE通过修模海量数据中的词、实体及实体联系,研习确实寰宇的语义学问。相较于BERT研习局限说话共现的语义体现,ERNIE直接对语义学问实行修模,巩固了模子语义体现技能。

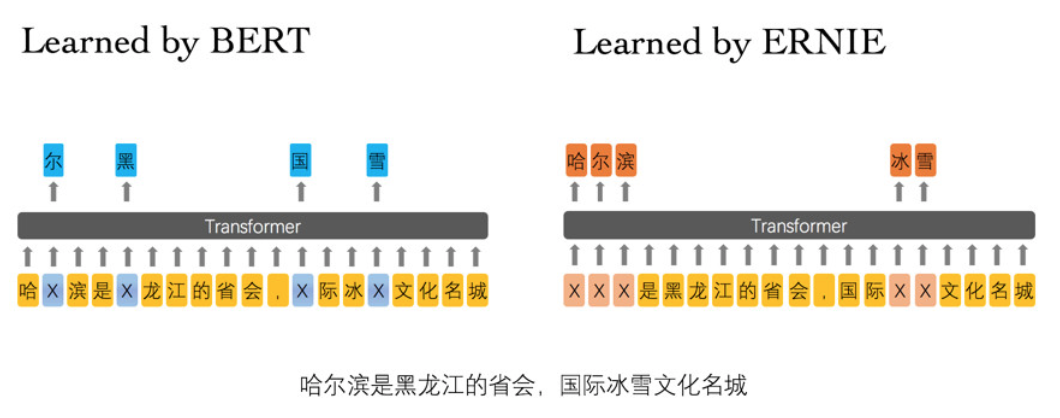

正在 BERT 模子中,通过『哈』与『滨』的局限共现,即可判别出『尔』字,模子没有研习与『哈尔滨』相干的学问。而 ERNIE 通过研习词与实体的外达,使模子也许修模出『哈尔滨』与『黑龙江』的联系,学到『哈尔滨』是『黑龙江』的省会以及『哈尔滨』是个冰雪都市。

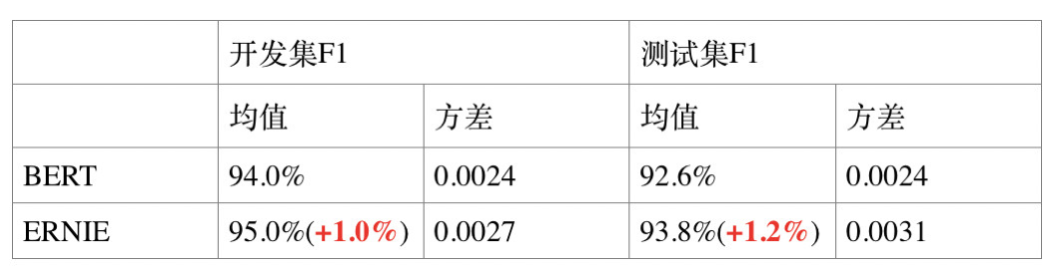

通过正在自然说话臆度、语义形似度、定名实体识别、心情领悟、问答般配 5 个公然的中文数据纠合前进行成效验证,ERNIE 模子相较BERT得到了更好的成效。

XNLI 由 Facebook 和纽约大学的酌量者纠合构修,旨正在评测模子众说话的句子体会技能。宗旨是判别两个句子的联系(抵触、中立、包含)。

LCQMC 是哈尔滨工业大学正在自然说话处分邦际顶会 COLING2018 构修的题目语义般配数据集,其宗旨是判别两个题目的语义是否一致。

ChnSentiCorp 是中文心情领悟数据集,其宗旨是判别一段话的心情立场。

MSRA-NER 数据集由微软亚研院颁布,其宗旨是定名实体识别,是指识别文本中具有特定事理的实体,紧要席卷人名、地名、机构名等。

NLPCC-DBQA 是由邦际自然说话处分和中文估计集会 NLPCC 于 2016 年举办的评测职业,其宗旨是采取也许回复题目的谜底。